Доброго часу доби, шановні читачі. Не так давно, кажучи про внутрішню оптимізацію сайтів, в основному мали на увазі роботу з контентом, з тегами HTML, зараз же, можна з упевненістю стверджувати, що внутрішня оптимізація сайтів давно вийшла за ці рамки. І сьогодні, обговорюючи оптимізацію сайтів під пошукові системи, неможливо залишити поза увагою тему внутрішньої структури сайту, його навігацію, службові файли, такі як robots.txt і sitemap.xml. Про це і піде сьогодні мова на прикладі CMS WordPress.

Продумуємо структуру сайту

Будь-які блогові платформи будуються за єдиним принципом, на головній сторінці виводяться всі записи, незалежно від того, якою рубрикою вони належать і чи є взагалі ці рубрики. Але в багатофункціональному WordPress можна реалізувати будь-яку навігацію, забороняти виводити на головній певні рубрики, підключати статичні сторінки, на яких можна виводити списки статей з кількох рубрик.

Напевно, швидше фантазія вичерпається, ніж вичерпаються можливості WordPress. І за всіма цими надмірностями можна забути про таку просту річ, як структура сайту і зручна навігація по ньому.

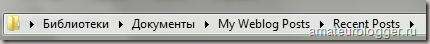

Варто, напевно, уточнити, що я маю на увазі під структурою сайту. Відкриваючи будь-яку папку на своєму комп'ютері, ми можемо простежити шлях будь-якого документа, його батьківську папку, в якій директорії папок він знаходиться.

Так і на сайті будь-який документ (сторінка) має свою директорію. І від вас залежить, яке місце ви задасте кожній сторінці свого блогу. Але, як для вашого користувача, так і для пошукового робота структура вашого сайту повинна бути максимально прозорою і інтуїтивно зрозуміла. Не дарма, в своїх рекомендаціях і Яндекс і Google приділяють цьому не останнє значення.

Продумавши внутрішню структуру свого сайту, необхідно визначити, як ця структура буде відображатися в адресному рядку, які параметри URL будуть використані.

налаштовуємо ЧПУ

Правильно налаштовані URL адреси називається ЧПУ - людино-зрозумілі урли.

Зараз пошукові системи настійно рекомендують встановлювати людино-зрозумілі урли, які відображали б зміст сторінки. У WordPress за замовчуванням стоять URL з використанням знака питання і ID поста і це необхідно виправити в розділі Параметри - Постійні посилання.

Тут в першу чергу необхідно визначитися, чи буде в адресі сторінки присутня назва вашої рубрики:

http://mysite.ru/category/ name_category / name_post

Або в URL взагалі не буде доступний широкому повний шлях документа:

http://mysite.ru/name_post

Звертаю вашу увагу на те, що слово category в URL вказується за замовчуванням, але про це трохи нижче.

Цей момент дуже важливий, і варто серйозно подумати, перш, ніж зробити що-небудь.

У першому випадку великою перевагою є те, що положення документа в структурі всього сайту чітко простежується, значно спрощуючи життя вашим користувачам / читачам, але при цьому, значно подовжує сам URL, особливо, якщо структура сайту має вкладені категорії.

Однак, існують різні плагіни або ручні методи для того, щоб прибрати слово category з адреси сторінки. Радити в даній статті нічого не буду з тієї причини, що плагін варто підбирати індивідуально, пробувати різні, тому що не на всіх блогах коректно працюють, а тема поста сьогодні не про це.

Другий варіант виходить значно коротше, але при цьому, для користувачів менш зрозумілий. Особисто я гублюся на сайтах, у яких складна структура і при цьому в адресному рядку не відображається моє місцезнаходження.

Хоча ця проблема вирішується, наприклад, за допомогою, так званих, хлібних крихт, коли перед статтею позначений шлях від головної сторінки через рубрики до сторінки, на якій я перебуваю в даний момент (для WordPress є спеціальний плагін для цього Breadcrumb NavXT.

Отже, ви самостійно повинні вирішити, які сторінки хочете мати на своєму блозі.

Якщо ви віддали перевагу перший варіант http://mysite.ru/category/ name_category / name_post, то відзначаєте поле Довільно і вказуєте: /% category% /% postname% /

Отже, якщо ви встановили такий варіант постійних посилань, то тепер ви можете для слова category в url, вказати інше, більш коротке значення, наприклад, cat:

В такому випадку, ваша посилання http://mysite.ru/category/ name_category / name_post перетвориться в такий вигляд:

http://mysite.ru/cat/ name_category / name_post.

Або можете підшукати плагін, який без проблем взагалі прибере слово category з url-адрес.

Якщо ж ви вибрали другий варіант посилань http://mysite.ru/name_post, то вказуєте тільки /% postname% /

Дуже важливо зробити всі ці настройки відразу, як тільки ви встановили свій блог і ще не наповнили його інформацією, особливо, якщо ви захочете приховати частину url за допомогою спеціальних плагінів.

Якщо ви вже наповнюєте свій блог статтями, то установка плагіна, що приховує слово category, або ручне втручання в код, може привести до того, що деякі сторінки блогу почнуть віддавати 404 помилку, тобто ні знайдено, тому що перебуватимуть за новими адресами.

Залишається ще одна важлива деталь, яка стосується налаштування ЧПУ. Справа в тому, що після установки значення /% postname% /, все URL-адреси буду формуватися з заголовка статті в той момент, коли ви вкажете цей заголовок при написанні поста

Як бачите, в URL кирилиця. Не дивлячись на розвиток кириличних доменів в зоні .рф, я дотримуюся тієї думки, що якщо домен має латинське написання, то і закінчення посилання повинно бути написано латиницею. Для цього ви можете, або кожен раз в ручну вказувати латинське написання (для цього є кнопка Змінити), або необхідно встановити спеціальний плагін RusToLat або RustoEng, який буде в автоматичному режимі переводити кирилицю в латиницю.

Розібравшись з налаштуванням ЧПУ, можна перейти до установки такого файлу, як sitemap.xml.

файл sitemap.xml

Файл sitemap.xml - це файл, в якому перераховуються url-адреси всіх сторінок вашого сайту в спеціальному форматі. Файл sitemap.xml завжди знаходиться в директорії сайту і має адресу: http://mysite.ru/sitemap.xml.

З одного боку, наявність цього файлу не є обов'язковим, але, я вважаю, він досить важливий, тому що тільки завдяки йому ми можемо повідомити пошуковій системі про те, які сторінки взагалі є на нашому сайті, особливо в тих випадках, якщо використовується складна навігація по сайту, так само, пошукові системи постійно перевіряють ці файли на наявність оновлень. Наприклад, ви давно не писали в свій блог, і пошуковий робот не заходив індексувати його, але при цьому він постійно дивиться, чи не з'явилася якась нова інформація в вашому файлі sitemap.xml.

Цей файл можна складати, як вручну (для невеликих проектів, одного разу я цим займалася для одного статичного сайту) або, що більш зручно і актуально для сучасних динамічних сайтів, скористатися спеціальним плагіном, який в автоматичному режимі формує список всіх сторінок вашого блогу. І навіть використовуючи плагін, якщо у вас виникне необхідність внести зміни в цей файл, це завжди можна зробити безпосередньо через FTP або панель хостера.

Для WordPress найпопулярнішим плагіном, який формує файл sitemap.xml є Google XML Sitemaps .

Так само, існують окремі файли sitemap.xml, наприклад, для мультимедійного контенту, відео-роликів.

Останні версії WordPress - мультісайтового, тобто на одному сайті / блозі можна створювати велику кількість інших блогів, які можуть вести зареєстровані користувачі. Виглядати це буде, приблизно, як блоги на Blogger, які все перебувають на домені blogspot.com. Так ось для таких випадків існує своя карта сайту, яка може об'єднувати всі блоги в єдиний зміст.

Якщо ви хочете налаштувати карту сайту для користувачів, то для цього існує спеціальний плагін, який ви повинні встановити і налаштувати. Детальніше можете прочитати в статті Як створити повноцінну карту сайту на WordPress .

файл Robots.txt

Після установки і настройки плагіна, наступним етапом повинна стати настройка файлу robots.txt. Я вже писала про те, що це дуже важливий документ для будь-якого сайту, за допомогою якого ми можемо управляти індексацією свого ресурсу.

Тільки з його допомогою ми можемо сказати пошуковому роботу, які сторінки необхідно індексувати, а які ні. І як вже не раз говорила, для пошукової системи дуже важливо показувати користувачам саме ті сторінки, які максимально відповідають на питання користувачів.

Якщо ж через непродуману структури сайту, або з іншої причини у вас створюється дублювання сторінок, то пошукова система може все схожі сторінки знизити в пошуковій видачі, тому що не зможе визначитися з тим, яка з них є першоджерелом.

Так само, завдяки цьому файлу ми можемо закривати спеціальні сторінки сайту, які взагалі не повинні з'являтися в пошуковій видачі.

Спочатку, я планувала описати, як настройку плагіна Google XML Sitemaps, так і весь процес складання файлу robots.txt вже в цій статті, але по ходу написання, бачу, що це займе дуже багато часу, а пост вийде сильно довгим.

Тому про налаштування файлу robots.txt дуже докладно буде в наступній статті. Буде дуже докладно тому, що я хочу не тільки дати готовий варіант цього файлу для WordPress, а пояснити всю технологію складання цього документа.

Оновлення: Стаття про файл robots.txt опублікована - Файл Robots.txt. оптимізація WordPress

Готовий файл robots.txt можна знайти на будь-якому блозі моєї і схожої тематики, проте, в мережі мало хороших статей, спрямованих, зокрема, на розуміння цього документа. А я вже зіткнулася з тим, що спочатку взяла готовий варіант, а потім ще шукала додаткову інформацію то з одного питання, то по іншому, кілька разів переробляла на що витратила додатково час.

Так само, швидше за все, опишу окремо настройку плагіна Google XML Sitemaps, тому що налаштувань дуже багато і не кожен зможе відразу розібратися в них.

Тому, не забуваємо стежити за оновленнями блогу. Вдалого всім розвитку.

Товаров:

Товаров: